菁菁校園 NAVIGATION

計(jì)算機(jī)學(xué)院研究生科研成果被CCF A類(lèi)國(guó)際學(xué)術(shù)會(huì)議ACM Multimedia 2021錄用為口頭報(bào)告論文

近日,2021國(guó)際頂級(jí)會(huì)議ACM Multimedia首次在四川成都舉辦,計(jì)算機(jī)學(xué)院朱艾春老師指導(dǎo)的2021級(jí)研究生王子杰同學(xué)的長(zhǎng)文“DSSL:Deep Surroundings-person Separation Learning for Text-based Person Retrieval”被大會(huì)錄用為Oral Presentation(口頭報(bào)告論文,錄用率約9%)。

ACM Multimedia有著嚴(yán)苛的錄用標(biāo)準(zhǔn),2021年的投稿量達(dá)2544篇,經(jīng)過(guò)Desk Rejects后有1942篇論文進(jìn)入審稿階段,最終大會(huì)僅錄用179篇口頭報(bào)告論文,363篇海報(bào)論文。ACM Multimedia是計(jì)算機(jī)學(xué)科多媒體領(lǐng)域的頂級(jí)國(guó)際會(huì)議,也是中國(guó)計(jì)算機(jī)學(xué)會(huì)(CCF)推薦的該領(lǐng)域唯一的A類(lèi)國(guó)際學(xué)術(shù)會(huì)議。

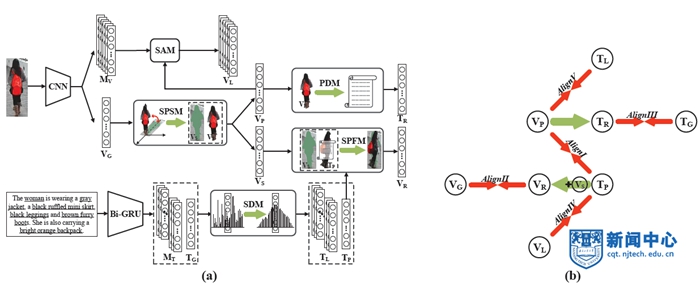

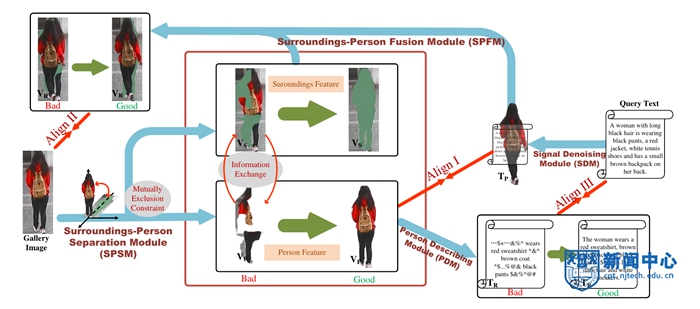

該論文針對(duì)跨模態(tài)行人重識(shí)別任務(wù)展開(kāi)研究,并提出了一種深度環(huán)境行人分離學(xué)習(xí)模型(Deep Surroundings-person Separation Learning model, DSSL)。現(xiàn)有算法一般都致力于學(xué)習(xí)一個(gè)公共空間映射,以從異質(zhì)的多模態(tài)數(shù)據(jù)中提取富有鑒別能力的特征。但由于高維數(shù)據(jù)的復(fù)雜性,無(wú)約束的映射方法很難在正確捕捉行人特征的同時(shí)剝離掉干擾信息。論文提出了一種深度環(huán)境行人分離學(xué)習(xí)模型(DSSL),以進(jìn)行高效精準(zhǔn)的行人特征提取與匹配。如圖2及圖3所示,環(huán)境行人分離與融合機(jī)制(SPSM+SPFM)起到了關(guān)鍵性的作用,在信息正交約束下,通過(guò)行人特征的分離與跨模態(tài)融合重構(gòu)匹配,從而實(shí)現(xiàn)精準(zhǔn)的環(huán)境行人剝離與匹配,極大提升了模型精度。此外,為了進(jìn)一步推動(dòng)該課題后續(xù)研究的發(fā)展,該研究團(tuán)隊(duì)在MSMT17基礎(chǔ)上,構(gòu)建了一個(gè)全新的真實(shí)場(chǎng)景跨模態(tài)行人重識(shí)別數(shù)據(jù)集(Real Scenarios Text-based Person Reidentification dataset,RSTPReid),其中每個(gè)行人的5張圖像均由不同相機(jī)在不同的時(shí)間、地點(diǎn)、天氣、光照、視角等條件下拍攝得到。目前,該數(shù)據(jù)集發(fā)布在GitHub實(shí)驗(yàn)室主頁(yè)上:https://github.com/NjtechCVLab/RSTPReid-Dataset,以供其他學(xué)者學(xué)習(xí)和使用。

作者:計(jì)算機(jī)科學(xué)與技術(shù)學(xué)院;審核:萬(wàn)夕里、劉學(xué)軍

公網(wǎng)安備32011102010195號(hào)

公網(wǎng)安備32011102010195號(hào)